Könnte eine Maschine bald voraussagen, wer zum Mörder wird? Was nach Science-Fiction klingt, ist in Großbritannien bereits Realität im Versuchsstadium: Das britische Justizministerium setzt auf ein KI-gestütztes System, das das Risiko schwerer Gewaltverbrechen – insbesondere Mord – bei Personen unter Bewährungsaufsicht analysieren soll. Ziel: Schwerverbrechen erkennen, bevor sie geschehen.

Der sogenannte „Homicide Prediction Algorithm“ wird derzeit rein zu Forschungszwecken eingesetzt. Doch die Debatte ist entfacht – nicht nur über seine Wirksamkeit, sondern vor allem über seine ethische Tragweite.

Algorithmen auf Spurensuche – bevor ein Verbrechen geschieht

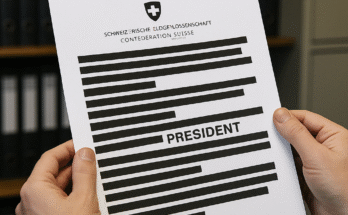

Laut Angaben des britischen Justizministeriums basiert das Programm auf umfangreichen Datenquellen. Im Fokus stehen Informationen des Strafvollzugs, der Polizei sowie psychiatrische und demografische Daten – wie Geschlecht, ethnische Zugehörigkeit oder psychische Vorerkrankungen. Doch genau hier beginnt die Kontroverse: Die britische Bürgerrechtsorganisation Statewatch berichtet, dass auch Daten von Personen einfließen, die nie verurteilt wurden – etwa Opfer häuslicher Gewalt oder Menschen mit suizidalen Tendenzen. Die Behörden weisen das entschieden zurück.

Der auf dem Gebiet der künstlichen Intelligenz spezialisierte Diplomingenieur Rüzgar ÜREN sagte: Mit ausreichenden Daten und dem richtigen Algorithmus ist es möglich, sogar die Zukunft vorherzusagen. Wenn jedoch die Daten, mit denen ein KI-Modell trainiert wird, voreingenommen oder nicht authentisch sind, kann das Modell völlig in die falsche Richtung gelenkt werden.

Künstliche Intelligenz – Wundermittel oder Gefahr für Grundrechte?

Die Diskussion um diskriminierende Algorithmen ist nicht neu – doch gerade im Strafvollzug hat sie besonderes Gewicht. Wenn bestimmte Gruppen bereits in der Vergangenheit häufiger überwacht wurden, tauchen sie in den Datensätzen auch häufiger auf. Das Ergebnis: Der Algorithmus stuft sie automatisch als risikoreicher ein – eine selbstverstärkende Spirale.

Ein Beispiel: Ein KI-System zur Bewerberauswahl würde, basierend auf historischen Daten, bevorzugt weiße Männer empfehlen – weil die in der Vergangenheit eingestellt wurden. Genauso kann eine „Vorhersage-KI“ im Strafvollzug bestimmte Gruppen automatisch kriminalisieren – nicht wegen individueller Taten, sondern wegen statistischer Häufigkeit.

Und die Schweiz? Zwischen Dateneuphorie und Realität

Auch in der Schweiz wurden KI-Ansätze zur Kriminalitätsprävention getestet – etwa zur Vorhersage von Einbrüchen. Doch die Resultate sind ernüchternd. Besonders im Kanton St. Gallen habe sich laut Berger gezeigt, dass der Nutzen begrenzt sei. „Bei Einbrüchen gibt es relativ viele Daten, aber bei schweren Gewaltdelikten ist die Datenlage zu dünn, um zuverlässige Prognosen zu machen.“

Trotzdem bleibt die Frage bestehen: Wird die Zukunft der Strafverfolgung durch Daten entschieden? Oder riskieren wir, Grundrechte algorithmisch auszuhebeln?

Fazit: Zwischen Prävention und Prophezeiung

Die Vorstellung, Verbrechen zu verhindern, bevor sie geschehen, ist verlockend – aber auch gefährlich. Wo endet die Analyse, wo beginnt die Vorverurteilung? KI kann ein mächtiges Werkzeug sein, doch ohne ethische Kontrolle droht sie, zum Richter über Menschen zu werden, bevor diese überhaupt gehandelt haben.

Die Gesellschaft steht vor einer neuen Herausforderung: Wie viel Kontrolle wollen wir Maschinen wirklich geben?

Taaarismorant Mowfcheschi

Können künstliche Intelligenz und die Zukunft ihre eigene Zukunft vorhersagen?

*🙏🙏🙏🙏🙏*